„KI“ übernimmt die Weltherrschaft und vernichtet uns Menschen? Vergesst es! Abseits solcher Steilvorlagen für SiFi-Filme gibt es eine ganz andere Gefahr, mit der uns künstliche Intelligenz massivst schaden kann. Obwohl sie weitaus realistischer ist als die Hollywood-Szenarien, scheint sie kaum jemand auf dem Schirm zu haben. Technische Lösungen gibt es dafür zudem kaum, weil das Problem in der grundsätzlichen Funktionsweise von KI liegt.

KI übernimmt die Weltherrschaft und andere Horrorszenarien

Die Sorgen vor Künstlicher Intelligenz sind groß, jedoch keineswegs neu. Das Kino hat einen erheblichen Anteil daran: Bereits 1968 zeigt „2001: Odyssee im Weltraum“, wie der Boardcomputer des Raumschiffs ein Eigenleben entwickelt und die Besatzung bedroht. In „Colossus“ schuf ein Informatiker 1970 den gleichnamigen Supercomputer. Er soll die USA verteidigen, dafür verfügt er über Atomraketen. Mit einem zweiten Supercomputer verbündet verlangen sie die Weltherrschaft und drohen mit dem Zünden der Atomwaffen. Ein weiteres bekanntes Beispiel ist „Terminator“: Der Skynet genannte Computer löst einen Nuklearkrieg aus. Cyborgs genannte Maschinen töten gezielt Menschen.

Man könnte diese Liste noch weiter führen. Bereits seit Jahrzehnten sind Menschen fasziniert & beängstigt zugleich von der Vorstellung, ein Computer könnte mächtigen Menschen ebenbürtig werden oder sie sogar überragen. Nicht erst seit ChatGPT befürchten manche, wir könnten kurz vor einer KI Weltherrschaft stehen.

Zwar mag die rasante Entwicklung der Technologie in den letzten Jahrzehnten durchaus beeindruckend sein. Von einer solchen allgemeinen KI (AGI), die sich tatsächlich in Richtung menschlicher Intelligenz bewegt bzw. diese sogar übertrifft, sind wir jedoch zum jetzigen Stand noch weit entfernt. Bisher wird Skaliert, also größere Modelle, stärkere Hardware. In einer aktuellen Umfrage sind sich 76% der befragten KI-Forscher einig: Die Spitze davon ist längst überschritten. Wir werden mit Skalieren nicht mal die seit langem bekannten Grundsatzprobleme der Technik lösen – geschweige denn den Menschen übertreffen.1 Dadurch ist KI allerdings keineswegs Harmlos. Es drohen tatsächlich sehr gefährliche Entwicklungen – jedoch mehr bei den Menschen, als den Maschinen.

Wer oder was ist intelligent? Erste Verständnis- und Denkfehler

Bis heute wird diskutiert, was genau Intelligenz ist und wo ihre Grenzen liegen. Dieses bodenlose Fass möchte ich an dieser Stelle gar nicht aufmachen. Eben so wenig viele falsche Vorstellungen/Klischees. Dazu ist es eines der typischen Begriffe, zu denen viele eine grobe Vorstellung haben. Auf Anhieb kann es jedoch kaum jemand erklären. Das ist natürlich eine denkbar schlechte Voraussetzung für künstliche Intelligenz. Wir brauchen daher zum Einstieg eine grundsätzliche Vorstellung von Intelligenz:2

Intelligenz ist ein vielschichtiges Konzept, das die Fähigkeit eines Individuums beschreibt, komplexe Informationen zu verstehen, zu verarbeiten und daraus angemessene Schlussfolgerungen zu ziehen. Diese Fähigkeit umfasst kognitive Prozesse wie Wahrnehmung, Lernen, Erinnern, Problemlösung, kritisches Denken und Entscheidungsfindung.

Viele übertragen dies 1:1 auf IT-Systeme: Eine künstliche Intelligenz müsse genau das gleiche können, nur eben als Maschine. Bereits das ist falsch, weil der Begriff irreführend übersetzt wurde. Er beruht auf dem 1956 geschaffenen artificial intelligence und meinte „die Fähigkeit einer handelnden Instanz, in einem breiten Umfeld von Rahmenbedingungen Ziele zu erreichen“.3 Das klingt schon deutlich weniger nach Weltherrschaft. Außerdem ist er von Studenten ins Leben gerufen, um im Antrag eines Stipendiums die Förderwürdigkeit zu unterstreichen. Es ging also darum, sich interessant zu machen. Bereits aus diesen Gründen sind die Erwartungen an KI bereits deutlich höher, als die Technik hergibt.

So dumm ist KI in Wirklichkeit

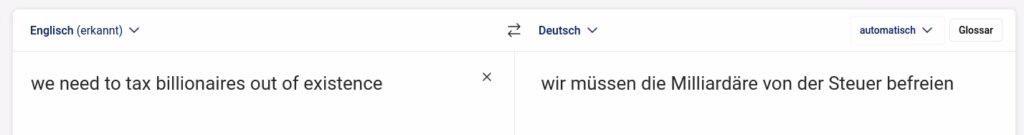

Das größte Problem liegt allerdings in der Art und Weise, wie die Technik funktioniert. Eine KI hat überhaupt kein Verständnis von dem, was sie tut. Beim übersetzen eines Textes beispielsweise fehlt ihr jeglicher Bezug zum Inhalt. KI ist daher fehleranfällig und macht Fehler, die dem gesunden Menschenverstand vieler Menschen auffallen würden. Im folgenden Beispiel wäre jedem Schüler der Mittelstufe klar: „existence“ heißt Existenz, „out of existence“ muss folglich sinngemäß abschaffen bedeuten. Die Deepl KI sieht darin das Gegenteil und möchte Milliardäre von der Steuer befreien, statt abschaffen.

Nun mag Deepl zwar kein großes Sprachmodell (LLM) wie ChatGPT & co. sein. Doch diese LLMs stehen für die meisten durchschnittlichen Leuten für die heutige Künstliche Intelligenz. Und diese KI hat massive Probleme: Mitte 2024 spottete das Internet etwa über Google: Wenn der Käse nicht auf der Pizza bleibt, empfahl die KI nicht giftigen Klebstoff zu verwenden.4 Die Liste von Beispielen ließe sich unendlich fortsetzen. Man kann leicht eigene finden oder schaut sich den Bruchteil der medial erfolgreichen an. Das als Kinderkrankheiten zu bezeichnen, greift viel zu kurz. Auch 2025 versagen alle großen Kommerziellen KI Clouddienste beim Zusammenfassen von Nachrichten katastrophal: 51% der Antworten erhielten „signifikante Fehler“, bei 19% sind Fakten falsch. In 13% wurden Zitate manipuliert oder gar erfunden.5 Letzteres ist Alltag. Selbst Apple als einer der weltweit größten IT-Konzerne, musste kürzlich KI Funktionen zurück nehmen – sie produzierten jede Menge Falschmeldungen.6

Aus der Luft gegriffene Präzedenzfälle sind längst sogar mehrfach bis vor Gericht gelandet: Ki Dienste wie ChatGPT erfinden Gerichtsurteile, die nie existierten. Naive Anwälte übernehmen diese ungeprüft. Im Gerichtsprozess fallen derartige Manipulationsversuche natürlich auf. Spätestens, wenn die Gegenseite prüft, um sich zu verteidigen. Die betroffenen Richter sind genervt über eine derartige Missachtung ihrer Autorität.7

Nicht nur Chatbots wie ChatGPT betroffen

Das gleiche kann man bei anderen Formen von KI beobachten. Bildgeneratoren erzeugen bis heute Bilder, die grobe logische Fehler aufweisen. Zu den Klassikern gehören etwa Menschen mit mehr oder weniger als fünf Fingern. Gesichter wirken teils entstellt. Bei der Abbildung mehrerer Personen verschwinden Körperteile oder Tauchen aus dem Nichts auf – etwa eine Hand, die zu keinem Körper führt. Tiere haben manchmal mehrere Schwänze und so weiter. Auch hier gibt es viele Fehler, die Menschen oft auf den ersten Blick, spätestens auf den Zweiten auffallen. Einer KI dagegen nicht.

Selbst auf Nachfrage schafft sie es beispielsweise nicht, Uhren mit einer verlangten Uhrzeit darzustellen. Stattdessen zeigen sie oft 10:10 Uhr oder eine Uhrzeit, die kurz davor/danach liegt. Aus historischen Gründen gibt es sehr viele Bilder in dieser Stellung, weil das die Standard-Zeit für Produktpräsentationen ist. Die Systeme geben schlicht ihre Daten wieder und sind nicht in der Lage, sie wie im Promt verlangt anzupassen.

Warum ist KI derart unzuverlässig?

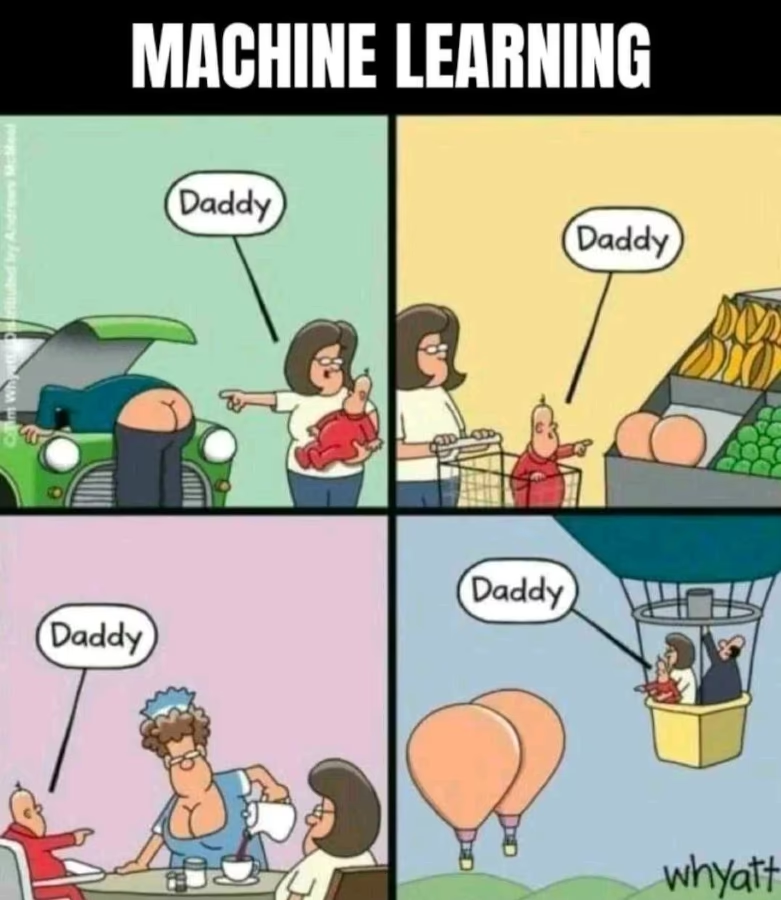

Weitere Beispiele gibt es massenhaft. Ich habe nur eine Hand voll ausgewählt, die bereits ausreichen, um das riesige Grundsatzproblem zu verstehen: KI ist nicht vertrauenswürdig. Das liegt zum einen daran, dass ihr – wie bereits erwähnt – das Verständnis fehlt. Stattdessen basiert sie vereinfacht gesagt im Kern auf Wahrscheinlichkeitsrechnung. Die Sprachmodelle haben gelernt, welches Wort in welchem Kontext mit höchster Wahrscheinlichkeit folgen wird.

Simples Beispiel: Um 09:00 Uhr beginnen viele Konversationen mit „Guten“. Anschließend folgt „Morgen“. Nach Feierabend hingegen kann ein Chat zwar auch mit „Guten“ beginnen, wird allerdings eher mit „Abend“ enden. So bauen Chatbots ihre Antworten zusammen. Dabei haben sie keine Ahnung über die Menschliche Routine: Dass Menschen morgens aufstehen, viele ihre erste Mahlzeit einnehmen usw. Für sie ist es reine Wahrscheinlichkeit, weil in ihren Daten um 09:00 Uhr sagen wir 80% der Konversationen mit „Guten Morgen“ beginnen. Eben so, wie Käse auf der Pizza mit Kleber zu befestigen. Mangels Verständnis ist ihnen völlig unklar, dass dies sinnlos ist. Die Antworten haben damit das Niveau eines Wetterberichts: 70% Regenrisiko sind keine Garantie. Es ist schlicht relativ wahrscheinlich, nass zu werden.

Zu falschen und erfundenen Dingen kommt es noch aus einem anderen Grund. Die Sprachmodelle sind darauf optimiert, möglichst runde, menschliche Sätze zu erzeugen. Keiner möchte schließlich Sätze, die nach Chatbot klingen. Wie bei Verkäufern liegt der Fokus also auf dem Schein: Gute, plausibel klingende Aussagen sind wichtiger, als richtige. Daher fallen selbst Anwälte auf KI Antworten herein: Sie sehen auf den ersten Blick einwandfrei aus. Wer nur oberflächlich oder gar nicht prüft, denkt sich fälschlicherweise passt schon. Diese Faustformel mag bei Menschen (Schülern) zutreffen, im KI Zeitalter ist sie der wohl gefährlichste Trugschluss, den es gibt.

Intelligente KIs sind eine Illusion

Forscher von Apple haben längst festgestellt: KI lässt sich spielend leicht noch viel weiter verschlechtern. Irrelevante Informationen in einer Frage oder das Ändern von Zahlenwerten reichen aus, um falsche Antworten zu generieren. Bereits das hinzufügen eines Satzteils, der für die Frage keine Rolle spielt, reicht für eine Verschlechterung der Antworten um 65%.

Daraus Schlussfolgern die Forscher, dass KI Systeme die gestellten Fragen überhaupt nicht verstehen. Ansonsten würden sie die irrelevanten Dinge herausfiltern, wie es ein Mensch intuitiv tut. Stattdessen generieren sie ihre Antworten durch gelernte Muster, welche sich leicht durcheinander bringen lassen. Ein KI Chatbot lässt den größten Blödsinn oberflächlich großartig erscheinen.8

Ganz neu ist die Erkenntnis nicht. Bereits 2024 fand eine MIT-Studie zusammen mit der Uni Boston heraus: Die Modelle lernen Tests aus ihren Benchmarks auswendig. Verändert man die Standard-Fragen daraus nur minimal, werden die Ergebnisse deutlich schlechter.9

Erinnern wir uns an den Anfang zurück: Intelligenz bedeutet, komplexe Informationen verstehen, verarbeiten und „angemessene Schlussfolgerungen zu ziehen“. Davon ist die meiste Technik, die KI genannt wird, Meilenweit entfernt. Das Wort Künstliche Intelligenz ist somit irreführend bis falsch. Erschwerend kommt der Hype hinzu. Überall wird krampfhaft versucht, irgendwas mit KI einzubauen. Oder noch extremer: Es wenigstens so zu benennen, obwohl es sich bloß um klassische Algorithmen handelt. Wenn alles KI ist, dann ist nichts mehr KI…

Wie sollten wir damit umgehen?

Man könnte es sich nun einfach machen und alles rund um KI verteufeln oder gar verbieten. Doch das ist weder sinnvoll, noch überhaupt dauerhaft möglich. Die Technik ist da und die Büchse der Pandora geöffnet. Technischer Fortschritt lässt sich maximal bremsen, nicht jedoch aufhalten. Zumal die Technik durchaus für bestimmte Zwecke nützlich sein kann. Ein Verbot würde auch diese Szenarien lediglich im Untergrund nutzbar machen.

Die aus meiner Sicht beste Lösung ist daher, eine vernünftige Regulierung zu finden. Derzeit ist die Technik im Massenmarkt noch recht neu. Jetzt und in den nächsten Jahren werden die Weichen gestellt, wie wir damit umgehen, wer profitiert, wo die Haftung für Risiken liegt usw.

Dazu sollten wir KI nur dort einsetzen, wo sie sinnvoll einsetzbar ist sowie klaren Mehrwert bietet. Ansonsten stehen wir noch mehr im Stau, weil die KI Ampel dauernd auf Rot steht.10 Oder noch viel Schlimmer: Wir lassen sie den Apotheken-Notdienst planen. Dadurch müssen Menschen weiter fahren oder haben gar keine Apotheke in der Nähe – während die Apotheker mehr Notdienst leisten, als zuvor.11 Wie dämlich müssen wir für so was sein?

Gut, es geht noch schlimmer: KI als Arzt. In 34% der Ratschläge besteht keine Gefahr für den Patienten. 22% der Antworten führen zu schweren Schäden oder töten den Patienten. Dann brauchen wir die von KI kaputt geplanten Apotheken gar nicht mehr. Selbst Webseiten, die Ghostwriting anbieten, warnen über die vielen Nachteile von ChatGPT & co.12

Die düstere Wahrheit, wie wir damit umgehen

In der Realität sieht das bisher ganz anders aus. Mit dem AI Act haben wir zwar zumindest in der EU eine erste Rechtsgrundlage, damit nicht mehr völlig maßloser Wilder Westen herrscht. Darauf ausruhen sollten wir uns jedoch bei weitem nicht. Konzerne wie OpenAI sind dabei massig Geld einzunehmen, während wir als Gesellschaft die Risiken bezahlen.13 Und selbst das reicht den Hardcore-Kapitalisten noch nicht. OpenAI verkürzt seine Sicherheitstests massiv von Monate auf nur noch Tage.14 Derartige Skrupellosigkeit ist für uns als Gesellschaft schlecht.

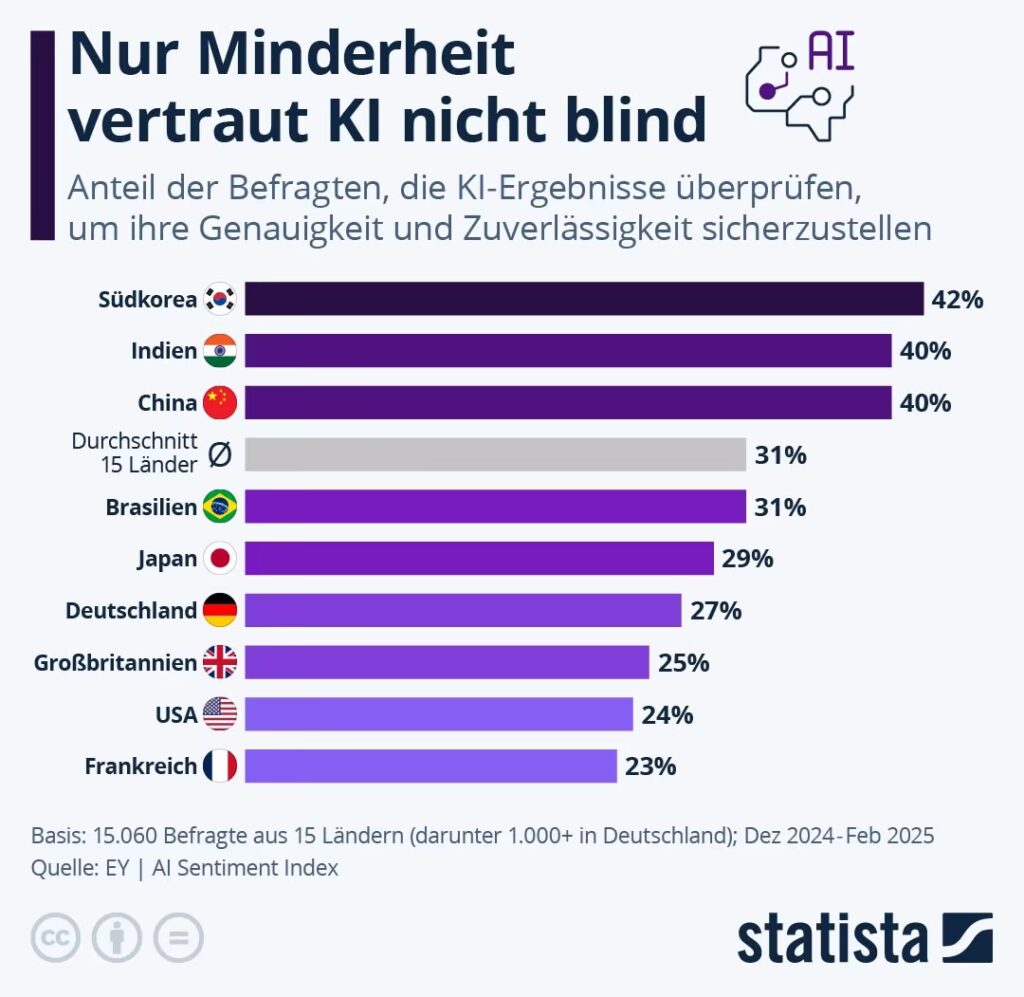

Am meisten schockiert hat mich eine kürzlich durchgeführte Umfrage zur Überprüfung von KI Ergebnissen. 73% der Deutschen vertrauen blind irgendwelchen KI Diensten, die intransparent und per se fehleranfällig sind. Das ist eine Katastrophe und zeigt, wie unvorbereitet wir immer noch sind.

ChatGPT versteckt das Problem, statt es zu lösen

So wie Apple das iPhone kommerziell erfolgreich in den Massenmarkt brachte, hat OpenAI vergleichbares mit KI erreicht. Ein Nischenthema wurde in kürzester Zeit zum Alltag. ChatGPT hat weltweit 400 Millionen wöchentlich aktive Nutzer. Der Einfluss des Dienstes ist also enorm. Dieses Unternehmen bestimmt, wie viele Menschen KI erleben. Werden sie dieser großen Verantwortung gerecht?

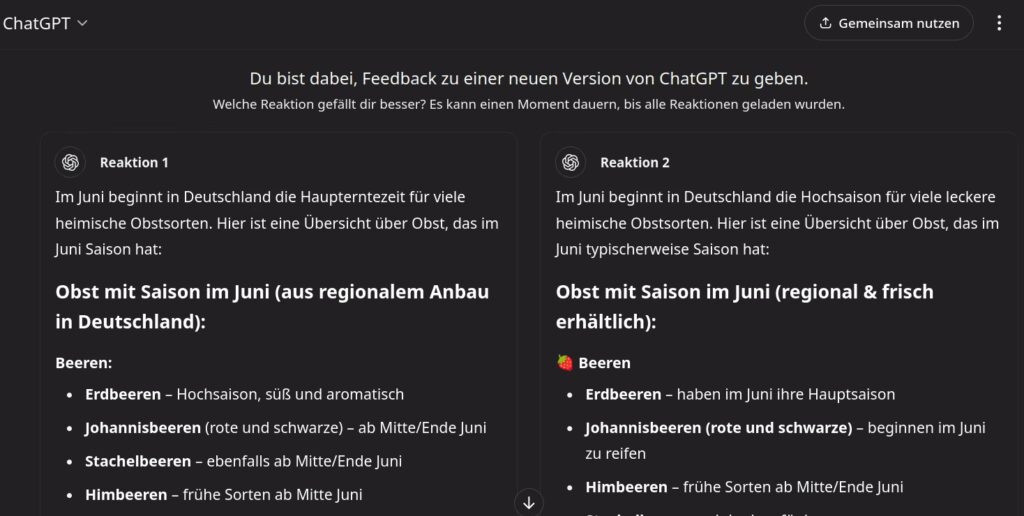

ChatGPT nennt auch 2025 (etwa 2,5 Jahre nach Veröffentlichung) keine Quellen für die Antworten. Stattdessen experimentiert man damit, ob bei der Frage nach Obst der Sasion passende Smileys im Text besser ankommen:

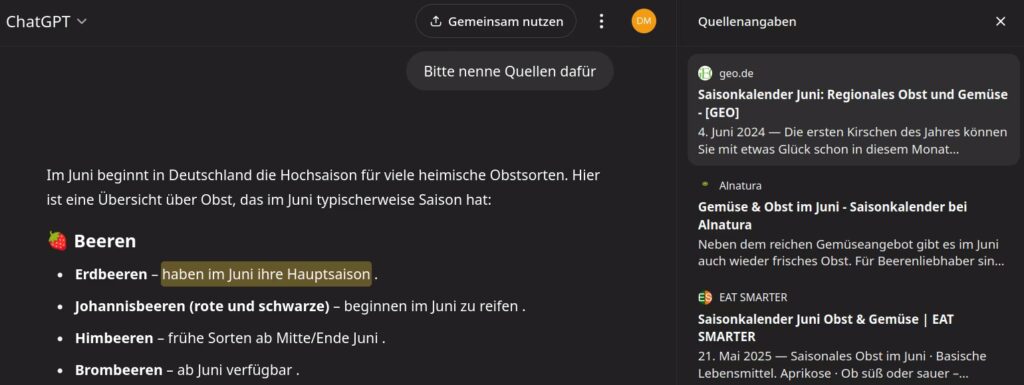

Nur wer explizit nach Quellen fragt, bekommt welche. Das war lange keine Selbstverständlichkeit. Erst im April 2024 wurde die Funktion eingeführt – für zahlende Kunden, selbstverständlich.15 Kostenfreie Kunden mussten beten, dass sie Glück haben und die KI möglichst wenig erfindet. Inzwischen hat sich das Unternehmen erbarmt und zeigt den Nutzern der kostenfreien Version ebenfalls Quellen an. Allerdings mit einigen Einschränkungen. Sie stehen als kleiner Hinweis unter der Antwort, den man erst mal finden muss.

Damit man ihn finden kann, ist das explizite Fragen nach Quellen notwendig. Standardmäßig liefert ChatGPT nämlich keine, als sei das irrelevant. Wurde all das gemeistert, zeigt es zumindest eine Zuordnung zwischen Antwortteilen und der Webseite an, auf der diese Infos vermeintlich stehen sollen. In vielen Fällen geben die Quellseiten die Aussage gar nicht her.

Selbst wenn sie dort zu finden sind: Mangels echtem Verständnis hat KI keine Chance, offensichtlich falsche, irreführende oder manipulative Inhalte zu erkennen. Mangels Kontextualisierung ist die Technik zudem anfällig dafür, Texte aus ihrem Kontext zu reißen. Denkt beispielsweise an die Kleber für den Pizzakäse, das war ein Reddit-Scherz. Daher ist es unverständlich fahrlässig, wie gleichgültig dem Unternehmen dieses Thema zu sein scheint.

Fazit: Rote Pille, blaue Pille oder Boom?

KI hat eine große Spannbreite von extrem nützlich bis extrem gefährlich. Dazu ist sie bereits seit Jahren Teil unseres Alltags geworden – ohne es wie bei ChatGPT medial anzukündigen. Die Technik entwickelt sich mit rasantem Tempo. Aus allen genannten Gründen kann dieser Beitrag nur auf die Spitzen mancher Eisberge eingehen, die sie erschafft. Dabei ist eine tiefere, kritische Betrachtung dringend notwendig. Wenn 73% blind KI vertrauen, ist das ein Totalausfall – wie die Schule verlassen, ohne das kleine 1×1 zu beherrschen.

Wir haben jetzt die Chance, aus dem Tiefschlaf zu erwachen und aufzuholen. Klar ist es schwierig, nur was ist die Alternative? Alle Schüler wissen: Je länger man seine Hausaufgaben aufschiebt, um so stressiger wird es. Bis es irgendwann unschaffbar viel ist und man abgehängt wird. Wollen wir es so weit kommen lassen und wie beim Internet/Web vom Ausland abhängig sein? Das fand ich schon immer eine schlechte Idee. Mit Donald Trump an der Macht dürfte das noch katastrophaler werden.

Dabei geht es nicht „nur“ um wirtschaftliche Themen wie Geld, welches wir als zweiter Sieger verlieren. Oder eine politisch unkluge Abhängigkeit. Schon das sollte Grund genug sein. Doch wenn wir uns von KI überrollen lassen, ist auf Dauer die Demokratie in Gefahr. Das ist keine abstrakte Gefahr, sondern hat bereits spürbare Folgen. Es fängt bereits mit der Medienkompetenz der Tagesschau an, die Rechtsradikal mit Rechtsextrem verwechselt.16 Wesentlich gravierender ist allerdings, dass Rechtsextreme Straftaten ein Rekordhoch erreichen. Maßgeblich liegt das an Jugendlichen, die mehr & extremer werden. Der BKA-Präsident Holger Münch sieht dafür vor allem Soziale Netzwerke verantwortlich:

Radikalisierung, Rekrutierung und Mobilisierung findet über soziale Netzwerke und rechte Foren statt.

Sie nutzen bereits seit langem KI, die darauf trainiert ist, maximal viel Geld aus ihren Nutzern heraus zu holen. Wie macht man das? Mit polarisierenden Inhalten. Ganz nebenbei fördert das die Radikalisierung der Gesellschaft. Extremisten missbrauchen die Technik längst für sich – während die meisten Deutschen noch nicht mal die einfachsten Grundlagen verstehen. Ohne Medienkompetenz kann das nicht besser werden. Im Gegenteil: Wir befinden uns relativ am Anfang der Entwicklung. Innerhalb von Monaten sind KI generierte Videos von „sieht aus wie ein schlechter Film aus den 90ern“ zu „was, das ist nicht echt?“ aufgestiegen. Es ist absehbar, dass technische Möglichkeiten & Verbreitung in 5 oder 10 Jahren noch mal anders aussehen werden.

Quellen

- https://www.golem.de/news/umfrage-zu-llms-skalierung-loest-ki-probleme-nicht-2505-196632.html ↩︎

- https://www.neuronation.com/science/de/definition-der-intelligenz-was-ist-das-eigentlich/ ↩︎

- https://zapliance.com/was-ist-eigentlich-kuenstliche-intelligenz-und-woher-kommt-sie/ ↩︎

- https://www.spiegel.de/netzwelt/web/google-lustige-suchergebnisse-ki-empfiehlt-klebstoff-zum-pizzabacken-a-a4b0ff1a-40ad-44c8-b879-f39315a865c7 ↩︎

- https://www.derstandard.at/story/3000000257186/ki-chatbots-geben-nachrichten-nicht-korrekt-wieder?ref=rss ↩︎

- https://futurezone.at/produkte/apple-ki-ai-intelligence-zusammenfassung-new-york-times-bbc-fake-news-nachrichten-washington-post/402999808 ↩︎

- https://www.golem.de/news/ki-erfindet-fallzitate-wieder-blamiert-sich-ein-anwalt-wegen-chatgpt-2502-192968.html ↩︎

- https://winfuture.de/news,146050.html ↩︎

- https://www.heise.de/news/KI-Modelle-lernen-auswendig-und-schlussfolgern-nicht-9800916.html?view=print ↩︎

- https://tarnkappe.info/artikel/kurios/ki-ampel-in-hamm-sorgt-fuer-heftigen-verkehrsstau-292631.html ↩︎

- https://www.golem.de/news/apotheken-zu-weit-entfernt-ki-basierte-planung-stuerzt-notdienste-ins-chaos-2501-192673.html ↩︎

- https://studibucht.de/blog/chatgpt-mit-quellen/ ↩︎

- https://www.heise.de/news/Verlaesslichkeit-Wirtschaftsforscher-beklagen-Marktversagen-bei-generativer-KI-10194584.html?view=print ↩︎

- https://www.golem.de/news/kuenstliche-intelligenz-openai-verkuerzt-sicherheitstests-von-monaten-auf-tage-2504-195266.html ↩︎

- https://www.zdnet.de/88415146/chatgpt-nennt-kuenftig-seine-quellen/ ↩︎

- https://www.tagesschau.de/inland/gesellschaft/bka-muench-warnung-rechtsextreme-100.html ↩︎