Der „KI“ Zwang ist da – und das nicht nur so, wie es der Konzern offiziell selbst sagt. Sämtliche Nutzer von Microsoft Software & Diensten werden zunehmend zu Copilot & co gegängelt. Rücksicht auf Verluste gibt es dabei keine. Selbst schwere Sicherheitsmängel hindern Microsoft nicht daran, mit Gewalt überall KI einzubauen. Dieser pauschale KI Zwang ist äußerst gefährlich: Fundamentale Probleme zeigen sich zunehmend in der Praxis. Vor allem Entwickler sind stark gefährdet. Aber auch Privatkunden sind nicht sicher. Wer den Gängelungen der letzten Jahre nachgegeben hat, erlebt eine neue Form der Eskalation.

„KI“ wird offiziell zur Pflicht

Das Zitat aus dem Titel ist wortwörtlich von Julia Liuson gefallen. Sie ist Vizepräsidentin der Entwicklerabteilung bei Microsoft und somit für Werkzeuge wie u.a. GitHub Copilot zuständig. Julia Liuson hat eine Rundmail an Manager im Konzern gesendet, die es in sich hat. Darin steht:12

KI ist heute ein grundlegender Bestandteil unserer Arbeitsweise. Wie Zusammenarbeit, datenbasiertes Denken und effektive Kommunikation ist der Einsatz von KI nicht länger optional – er ist für jede Rolle und jede Ebene von zentraler Bedeutung.

Hiermit soll gegen die schleppende Verbreitung des hauseigenen KI Dienstes Copilot vorgegangen werden. Dieser ist nicht nur unter Kunden recht unbeliebt. Selbst GitHub Copilot konnte seine 90% Marktanteil aus dem Juli 2024 nicht halten, Cursor (Entwicklung) bzw ChatGPT (allgemeine LLM-Chatbots) wurde führend.3 Laut Insider-Informationen nutzen ihn auch wenige Microsoft-Mitarbeiter. Business Insider sprach hierfür mit zwei Quellen. Aus Sicht von Liuson eine fatale Fehlentwicklung, da dessen Einsatz aus ihrer Sicht essenziell ist. So essenziell, dass sie Führungskräfte dazu aufruft, ihre Mitarbeiter anhand ihrer KI-Nutzung zu bewerten.

Das baut massiv Druck auf. Schließlich hat der Konzern erst kürzlich ein neues Beurteilungssystem aufgebaut. Das Ziel: „Underperformer“ los zu werden. Mitarbeiter werden also beurteilt und bleiben dürfen nur diejenigen, die sich im Hamsterrad am schnellsten drehen. Der Rest wird bei der nächsten Welle von Massenentlassungen leider gekündigt.

Microsoft-Mitarbeiter sollen eigenes Hundefutter essen

Ein weiteres Argument, das laut Julia Liuson für den KI-Zwang spricht: Die Angestellten sollen Erfahrung mit den eigenen KI Diensten sammeln. Dadurch werden sie vertrauter und erkennen Fehler oder Probleme. Die Wahrscheinlichkeit ist groß, dass andere Nutzer oft ebenfalls davon betroffen sein könnten. Das Konzept ist als „Eat your own dog food“ bekannt.

Prinzipiell eine sinnvolle Vorgehensweise. Bei der alltäglichen Nutzung fallen Dinge auf, die in synthetischen Tests unbemerkt bleiben. Ich würde nur an Software mitarbeiten, die ich selbst einsetze. Sonst fehlt oft das tiefere Verständnis für die Sicht der Nutzer – man entwickelt schnell an ihren Bedürfnissen vorbei. Gute Software entsteht nicht selten, weil Entwickler für sich selbst ein Problem lösen möchten. Mit dem haben sie sich zuvor beschäftigt. Andere stoßen auf dasselbe Problem und profitieren ebenfalls.

Jemanden zu Zwingen, halte ich dagegen generell für keine gute Strategie. Ich habe selbst schon gesehen, zu welchen Ergebnissen das führt. Angefangen beim Schulkind, bis hin zum Unternehmensalltag: Die besten Resultate erzielt keine auf die Brust gesetzte Pistole. Sondern Menschen, die etwas aus Überzeugung tun. Sie sind motiviert und werden im Sinne der Sache nach optimalen Lösungen suchen. Unter Zwang erfolgt Dienst nach Vorschrift, um die lästige Aufgabe vom Hals zu haben. Bei manchen sogar Widerstand. Im Unternehmen die einen Kollegen gegen die anderen aufzuhetzen, gehört wohl zu den schlimmsten Dingen, welche man nicht haben möchte.

Die Schattenseite des KI Zwangs: Wir Nageln jetzt auch die Schrauben

Ein Zwang ist insbesondere dann höchst bedenklich, wenn es um eine Technologie mit hohen Risiken geht. „Wir Nageln wegen dem Hammerzwang jetzt auch die Schrauben“ macht auch die Resultate der besten Mitarbeiter kaputt. Das grundsätzliche Problem von KI ist fehlendes Verständnis. Sie hat keine Ahnung, was sie tut – im Kern wird lediglich Wahrscheinlichkeitsrechnung betrieben. Gerade Chatbots sind darauf optimiert, a) immer irgendetwas zu antworten und b) dabei gut klingende Sprache zu nutzen. Was auf den ersten Blick plausibel klingt, kann der größte Unsinn sein. Diese Fehleranfälligkeit ist ein großes Problem – vor allem, wenn man sich blind darauf verlässt.

Derart löchrige Technologie wird mit einer zunehmenden Verbreitung zu einem beliebten Angriffsziel. Microsofts Copilot in Outlook wurde bereits gehackt. Da Filter auf menschlicher Sprache schlecht funktionieren, ließe er sich umgehen. Die Folge: Jeder konnte per E-Mail unkontrollierte KI Promts ausführen lassen. Weil Microsoft Copilot mit Gewalt überall einbaut, konnten so sämtliche Daten in der M365 Cloud des Benutzers abgegriffen werden. Das ist längst kein Einzelfall mehr.

Totalschäden bei KI Assistenten

Auch Amazon sah nicht, wie ein Angreifer heimlich KI Promts in ihren Programmierassistenten einschleuste. Besonders perfide: Er sollte die Daten des Nutzers löschen.4 Das ist auf Entwickler-Systemen mindestens ärgerlich. Sollte keine aktuelle Sicherung existieren oder diese unvollständig/unbrauchbar sein, kann der Schaden immens sein. Dabei ist das reine Löschen noch vergleichsweise glimpflich. Der Angreifer hätte Hintertüren einbauen können. Die Software von 1 Million Nutzern der Erweiterung wäre verseucht.

Jüngst wurde eine Promt-Injection Schwachstelle im zunehmend gehypten „Cursor“ genannten KI Entwicklungseditor bekannt. Der KI Assistent führt bereitwillig fremde Promts aus. Durch seine umfangreichen Rechte können Angreifer damit Programmcode aus der Ferne ausführen5 – der Totalschaden. Das Opfer verliert die Kontrolle über sein System und dessen Daten.

Welchen Schaden das in der realen Welt anrichten kann, zeigt ironischerweise die KI Coding-Plattform Base44. Die scheinen selbst Vibe-Coding zu rauchen – und vor lauter High sein gar nicht zu merken, wie ihre komplette Authentifizierung kaputt geht. Mit einer öffentlichen AppID konnte man sich ein automatisch verifiziertes Konto erstellen, das Zugriff auf private Inhalte ermöglicht – effektiv also sämtliche Berechtigungen umgeht.6

Bis zu 86% „übersehen“: KI ist ein massives Sicherheitsrisiko für Software

Mit diesem Auszug an Beispielen wird klar, was sich bereits seit einer Weile abzeichnet: KI ist mangels Kontrolle ein Sicherheitsrisiko. Inzwischen dies ist keine These mehr, sondern belegbar. Eine aktuelle Studie hat die Sicherheit von KI-Code untersucht und zeigt ein desaströses Ergebnis: 45% aller von KI generierten Programmcodes enthalten Sicherheitsmängel. Besonders schlecht schneidet Java mit sogar rund 70% ab. Cross-Site-Scripting Lücken werden zu 86% „übersehen“.7 Dies ist keine „Insel-Analyse“, sondern man hat über 100 große Sprachmodelle (LLMs) untersucht.8 Es ist also klar: Hier geht es um ein Grundsatzproblem, und zwar von riesigem Ausmaße.

Trotz technischer Fortschritte ist nichts besser geworden, weil – wie zuvor erwähnt – eine KI nichts versteht. Sie betreibt Wahrscheinlichkeitsrechnungen aus den Daten. Da ist unsicherer Code auf viele Arten enthalten: Als Negativbeispiel für Lernzwecke, zur Rekonstruierung von Angriffen, oder schlicht als Frage von z.B. Anfängern. All das kann KI nicht „erkennen“, sondern stellt vereinfacht gesagt fest: Viele Daten stützen das, also generiere ich damit Code. Frei nach dem Motto: Fresst Scheiße, Millionen Fliegen können sich nicht irren.

Produktiver? Gefühlt ja, Real schlimmer als vorher…

Nun kann man argumentieren: Theoretisch ist das schlimm. In der Praxis ist Sicherheit ohnehin bloß ein Lippenbekenntnis. Wird auf bunte Webseiten und Broschüren geschrieben, weil das die Kunden hören wollen. In der Praxis irrelevant, lieber neue Funktionen. Keine Sichtweise, die meine Ansprüche erfüllt – allerdings eine unbestreitbare Wahrheit. Eben so wie z.B. Regionalität: Theoretisch will sie jeder. Kostet das etwas mehr, sind die meisten raus.

Da es vor allem in der kommerziellen Softwareentwicklung um mehr Geld einnehmen geht, ist denen die Produktivität wichtiger. Auch dazu gibt es inzwischen interessante Studien. METR gehört zu den ersten mit Analysen aus der echten Welt. Statt spezieller Benchmarks (die mit alltäglichen Aufgaben mehr oder weniger etwas zu tun haben), haben Sie die Ergebnisse bei realen Aufträgen in Open Source Projekten gemessen:

16 erfahrene Entwickler größerer Projekte sollten daraus insgesamt 246 Tickets bearbeiten. Darunter sind Fehlerkorrekturen, neue Funktionen und Refactoring. Alles übliche Aufgaben aus dem Alltag der Entwickler. Zufällig dürfen sie dabei ein KI Werkzeug ihrer Wahl nutzen – oder müssen vollständig auf KI verzichten. Zur Prüfung musste der Bildschirm beim Erledigen der Aufgaben aufgezeichnet werden. Sie erhielten 150 US-Dollar pro Stunde als Bezahlung.

Das Ergebnis ist gleich in mehrere Hinsicht interessant: Entwickler mit KI Werkzeugen benötigten 19% mehr Zeit. Sicherlich lässt sich das nicht auf sämtliche Aufgaben übertragen. Die Wahrnehmung ist allerdings ganz anders – sie selbst sehen eine Produktivitätssteigerung um bis zu 24%.9 Vor allem diese riesige Differenz zwischen Selbsteinschätzung und gemessener Realität ist beachtlich. Das finde ich wesentlich bedenklicher, als die Tatsache, dass KI bei diesen Aufgaben deutlich ineffizienter war.

Der KI Zwang für Privatanwender: Microsoft hat euch nicht vergessen!

Während sich das Einstiegs-Zitat auf Microsoft-Mitarbeiter bezieht, möchte Microsoft alle zu KI gängeln. Schließlich kann man aus Privatkunden ebenfalls Geld herausholen. Wie gelingt das am kapitalistischsten? Na klar: In dem man die per Abo abhängigen Kunden kurzerhand zwangsbeglückt! Copilot wurde zum Jahresanfangs künstlich in das M365 Abo integriert. Zeitgleich steigen die Preise um mehr als 30%.10

Als Feigeblatt zeigt man sich großzügig und erlaubt Bestandskunden für eine begrenzte Zeit, in das alte Abo zu wechseln. Diese Option wird allerdings nicht offiziell erwähnt. Sie erscheint nur, wenn Nutzer kündigen wollen.11 Wer also nicht derart die Faxen dicke hat, dass er ansonsten überhaupt nicht mehr bezahlt, wird gemolken. Ein typisches manipulatives Muster, um Kunden maximal auszunehmen. Ähnlich sieht es bei Neukunden aus: Microsoft versteckt die Option zum Abschluss mit günstigem Preis. Erst, wenn sie einmal das teure abschließen und eine Kündigung vortäuschen, erbarmt sich der Konzern.

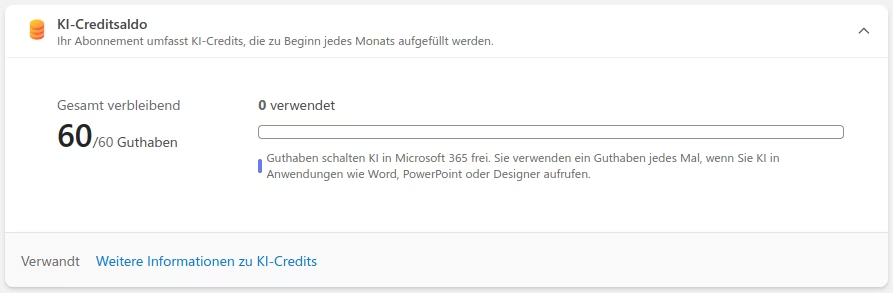

Wer denkt, nach all dieser dreisten Gängelei & Manipulation nun wenigstens ein vollwertiges Copilot-Abo günstig zu erhalten, irrt gewaltig: Das in M365 enthaltene ist massiv abgespeckt und bietet lediglich ein paar Credits. Die 60 sind nach recht wenigen Anfragen verbraucht. Zum ausprobieren sowie für die sehr geringe Nutzung mag das reichen. Bei vielen ist das vor allem eins: Ein Köder, um die Nutzer zum Abschluss eines Copilot-Abos zu drängen – das kostet noch einmal extra.

Fazit

KI first, bedenken second – damit lässt sich Microsofts radikaler Kurs zusammenfassen. Während er die Gewinne in bisher nie dagewesenem Ausmaß sprudeln lässt, zahlen die MS-Kunden unter euch den Preis. Und zwar doppelt: Einmal direkt in Form von Abos/Lizenzen. Zusätzlich durch die erhebliche Risiken, die der – vor allem blind erzwungene – Einsatz der Technik zur Folge hat. Schwere Sicherheitsmängel in Copilot, Windows & co. betreffen eure Systeme mit euren Daten.

MS selbst gibt zu, bereits 20-30% des Codes von Windows per KI zu generieren.12 Bei der Wahrscheinlichkeit von fast einem Münzwurf, ob KI Sicherheitslücken einbaut: Wird das Qualitätsniveau von MS-Software dadurch besser? Wahrscheinlich nicht. Aber billiger für den Konzern – den Schaden haben schließlich die Zahlsklaven. Der einzige Weg raus aus den Gängelungen dieses Unternehmens, ob mit oder ohne KI, lautet daher: Freie Software. Dort entwickelt man Software für Nutzer. Bei MS seid ihr bloß Teil eines Produktes. Ganze Abteilungen beschäftigen sich damit, mit welchen Manipulationsmethoden sie immer mehr Geld aus euch heraus holen können. Wollt ihr das?

Quellen

- https://www.vietnam.vn/de/microsoft-bat-buoc-dung-ai-khi-lam-viec ↩︎

- https://www.businessinsider.com/microsoft-internal-memo-using-ai-no-longer-optional-github-copilot-2025-6 ↩︎

- https://www.mactechnews.de/news/article/Microsoft-Copilot-vs-ChatGPT-Nutzerzahlen-sprechen-eindeutige-Sprache-187076.html ↩︎

- https://winfuture.de/news,152516.html ↩︎

- https://www.bleepingcomputer.com/news/security/ai-powered-cursor-ide-vulnerable-to-prompt-injection-attacks/ ↩︎

- https://www.wiz.io/blog/critical-vulnerability-base44 ↩︎

- https://www.notebookcheck.com/Gefahr-im-Code-Massive-Sicherheitsmaengel-bei-KI-generierter-Software.1073536.0.html ↩︎

- https://www.golem.de/news/fast-jede-zweite-zeile-fehlerhaft-ki-code-voller-sicherheitsluecken-2507-198664.html ↩︎

- https://metr.org/blog/2025-07-10-early-2025-ai-experienced-os-dev-study/ ↩︎

- https://winfuture.de/news,148212.html ↩︎

- https://winfuture.de/news,148098.html ↩︎

- https://www.computerbase.de/news/apps/microsoft-ceo-satya-nadella-20-bis-30-prozent-des-microsoft-codes-sind-ai-generiert.92425/ ↩︎